La Teoría Cuántica

por ENRIQUE LICCARDI SAÑUDO

Es un conjunto de nuevas ideas que explican los procesos incomprensibles para la física de los objetos.

La Teoría Cuántica es uno de los pilares fundamentales de la

Física actual. Recoge un conjunto de nuevas ideas introducidas en el primer tercio del siglo XX para dar explicación a muchos procesos incomprensibles por las concepciones físicas vigentes. Su aplicación se limita, a los niveles atómico, subatómico y

nuclear, donde resulta imprescindible. Pero también lo es en otros

ámbitos, como la electrónica, en la física de nuevos materiales, en la física de

altas energías, en el diseño de instrumentación médica, en la criptografía y la

computación cuánticas, y en la Cosmología teórica del Universo temprano. La

Teoría Cuántica es una teoría netamente probabilista: describe la probabilidad

de que un suceso dado acontezca en un momento determinado, sin especificar

cuándo ocurrirá. A diferencia de lo que ocurre en la Física Clásica, en la

Teoría Cuántica la probabilidad posee un valor objetivo esencial, y no se halla

supeditada al estado de conocimiento del sujeto, sino que, en cierto modo, lo

determina.

Hay que destacar el fuerte enfrentamiento que surgió entre las ideas de la Física Cuántica, y aquéllas válidas hasta entonces, digamos de la Física Clásica. Lo cual se agudiza aún más si se tiene en cuenta el notable éxito experimental que éstas habían mostrado a lo largo del siglo XIX, apoyándose básicamente en la mecánica de Newton y la teoría electromagnética de Maxwell (1865). Era tal el grado de satisfacción de la comunidad científica que algunos físicos, entre ellos uno de los más ilustres del siglo XIX, William Thompson (Lord Kelvin), llegó a afirmar:

"Hoy día la Física forma, esencialmente, un conjunto perfectamente armonioso, ¡un conjunto prácticamente acabado! ... Aun quedan “dos nubecillas” que oscurecen el esplendor de este conjunto. La primera es el resultado negativo del experimento de Michelson-Morley. La segunda, las profundas discrepancias entre la experiencia y la Ley de Rayleigh-Jeans."

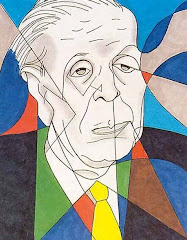

La disipación de la primera de esas “dos nubecillas” condujo a la creación de la Teoría Especial de la Relatividad por Einstein (1905), es decir, al hundimiento de los conceptos absolutos de espacio y tiempo, propios de la mecánica de Newton, y a la introducción del “relativismo” en la descripción física de la realidad. La segunda “nubecilla” descargó la tormenta de las primeras ideas cuánticas, debidas al físico alemán Max Planck (1900).

El origen de la Teoría Cuántica

La Ley de Rayleigh-Jeans (1899). Un fenómeno físico denominado radiación del cuerpo negro, es decir, el proceso que describe la interacción entre la materia y la radiación, el modo en que la materia intercambia energía, emitiéndola o absorbiéndola, con una fuente de radiación. Pero además de la Ley de Rayleigh-Jeans había otra ley, la Ley de Wien (1893), que pretendía también explicar el mismo fenómeno.

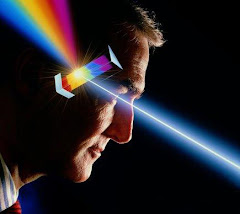

La Ley de Wien daba una explicación experimental correcta si la frecuencia de la radiación es alta, pero fallaba para frecuencias bajas. Por su parte, la Ley de Rayleigh-Jeans daba una explicación experimental correcta si la frecuencia de la radiación es baja, pero fallaba para frecuencias altas.

La frecuencia es una de las características que definen la radiación, y en general cualquier fenómeno en el que intervengan ondas. Puede interpretarse la frecuencia como el número de oscilaciones por unidad de tiempo. Toda la gama de posibles frecuencias para una radiación en la Naturaleza se hallan contenidas en el espectro electromagnético, el cual, según el valor de la frecuencia elegida determina un tipo u otro de radiación.

En 1900, Max Planck puso la primera piedra del edificio de la Teoría Cuántica. Postuló una ley (la Ley de Planck) que explicaba de manera unificada la radiación del cuerpo negro, a través de todo el espectro de frecuencias.

La hipótesis de Planck

¿Qué aportaba la ley de Planck que no se hallase ya implícito en las leyes de Wien y de Rayleigh-Jeans? Un ingrediente tan importante como novedoso. Tanto que es el responsable de la primera gran crisis provocada por la Teoría Cuántica sobre el marco conceptual de la Física Clásica. Ésta suponía que el intercambio de energía entre la radiación y la materia ocurría a través de un proceso continuo, es decir, una radiación de frecuencia f podía ceder cualquier cantidad de energía al ser absorbida por la materia.

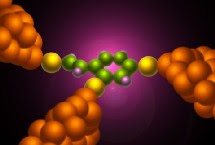

Lo que postuló Planck al introducir su ley es que la única manera de obtener una fórmula experimentalmente correcta exigía la novedosa y atrevida suposición de que dicho intercambio de energía debía suceder de una manera discontinua, es decir, a través de la emisión y absorción de cantidades discretas de energía, que hoy denominamos “quantums” de radiación. La cantidad de energía E propia de un quantum de radiación de frecuencia f se obtiene mediante la relación de Planck: E = h x f, siendo h la constante universal de Planck = 6’62 x 10 (expo-34) (unidades de “acción”).

Puede entenderse la relación de Planck diciendo que cualquier radiación de frecuencia f se comporta como una corriente de partículas, los quantums, cada una de ellas transportando una energía E = h x f, que pueden ser emitidas o absorbidas por la materia. La hipótesis de Planck otorga un carácter corpuscular, material, a un fenómeno tradicionalmente ondulatorio, como la radiación. Pero lo que será más importante, supone el paso de una concepción continuista de la Naturaleza a una discontinuista, que se pone especialmente de manifiesto en el estudio de la estructura de los átomos, en los que los electrones sólo pueden tener un conjunto discreto y discontinuo de valores de energía.

La hipótesis de Planck quedó confirmada experimentalmente, no sólo en el proceso de radiación del cuerpo negro, a raíz de cuya explicación surgió, sino también en las explicaciones del efecto fotoeléctrico, debida a Einstein (1905), y del efecto Compton, debida a Arthur Compton (1923).

Aplicación de la Teoría Cuántica

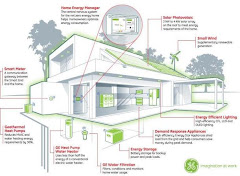

El marco de aplicación de la Teoría Cuántica se limita, a los niveles atómico, subatómico y nuclear, donde resulta totalmente imprescindible. Pero también lo es en otros ámbitos, como la electrónica (en el diseño de transistores, microprocesadores y todo tipo de componentes electrónicos), en la física de nuevos materiales, (semiconductores y superconductores), en la física de altas energías, en el diseño de instrumentación médica (láseres, tomógrafos, etc.), en la criptografía y la computación cuánticas, y en la Cosmología teórica del Universo temprano. De manera que la Teoría Cuántica se extiende con éxito a contextos muy diferentes, lo que refuerza su validez.

Pero, ¿por qué falla la teoría clásica en su intento de explicar los fenómenos del micromundo? ¿No se trata al fin y al cabo de una simple diferencia de escalas entre lo grande y lo pequeño, relativa al tamaño de los sistemas? La respuesta es negativa. Pensemos que no siempre resulta posible modelar un mismo sistema a diferentes escalas para estudiar sus propiedades.

Para ver que la variación de escalas es un proceso con ciertas limitaciones intrínsecas, supongamos que queremos realizar estudios hidrodinámicos relativos al movimiento de corrientes marinas. En determinadas condiciones, podríamos realizar un modelo a escala lo suficientemente completo, que no dejase fuera factores esenciales del fenómeno. A efectos prácticos una reducción de escala puede resultar lo suficientemente descriptiva.

Pero si reducimos la escala de manera reiterada pasaremos sucesivamente por situaciones que se corresponderán en menor medida con el caso real. Hasta llegar finalmente a la propia esencia de la materia sometida a estudio, la molécula de agua, que obviamente no admite un tratamiento hidrodinámico, y habremos de acudir a otro tipo de teoría, una teoría de tipo molecular. Es decir, en las sucesivas reducciones de escala se han ido perdiendo efectos y procesos generados por el aglutinamiento de las moléculas.

De manera similar, puede pensarse que una de las razones por las que la Física Clásica no es aplicable a los fenómenos atómicos, es que hemos reducido la escala hasta llegar a un ámbito de la realidad “demasiado esencial” y se hace necesario, al igual que en el ejemplo anterior, un cambio de teoría. Y de hecho, así sucede: la Teoría Cuántica estudia los aspectos últimos de la substancia, los constituyentes más esenciales de la materia (las denominadas “partículas elementales”) y la propia naturaleza de la radiación.

¿Qué aportaba la ley de Planck que no se hallase ya implícito en las leyes de Wien y de Rayleigh-Jeans? Un ingrediente tan importante como novedoso. Tanto que es el responsable de la primera gran crisis provocada por la Teoría Cuántica sobre el marco conceptual de la Física Clásica. Ésta suponía que el intercambio de energía entre la radiación y la materia ocurría a través de un proceso continuo, es decir, una radiación de frecuencia f podía ceder cualquier cantidad de energía al ser absorbida por la materia.

Lo que postuló Planck al introducir su ley es que la única manera de obtener una fórmula experimentalmente correcta exigía la novedosa y atrevida suposición de que dicho intercambio de energía debía suceder de una manera discontinua, es decir, a través de la emisión y absorción de cantidades discretas de energía, que hoy denominamos “quantums” de radiación. La cantidad de energía E propia de un quantum de radiación de frecuencia f se obtiene mediante la relación de Planck: E = h x f, siendo h la constante universal de Planck = 6’62 x 10 (expo-34) (unidades de “acción”).

Puede entenderse la relación de Planck diciendo que cualquier radiación de frecuencia f se comporta como una corriente de partículas, los quantums, cada una de ellas transportando una energía E = h x f, que pueden ser emitidas o absorbidas por la materia. La hipótesis de Planck otorga un carácter corpuscular, material, a un fenómeno tradicionalmente ondulatorio, como la radiación. Pero lo que será más importante, supone el paso de una concepción continuista de la Naturaleza a una discontinuista, que se pone especialmente de manifiesto en el estudio de la estructura de los átomos, en los que los electrones sólo pueden tener un conjunto discreto y discontinuo de valores de energía.

La hipótesis de Planck quedó confirmada experimentalmente, no sólo en el proceso de radiación del cuerpo negro, a raíz de cuya explicación surgió, sino también en las explicaciones del efecto fotoeléctrico, debida a Einstein (1905), y del efecto Compton, debida a Arthur Compton (1923).

Aplicación de la Teoría Cuántica

El marco de aplicación de la Teoría Cuántica se limita, a los niveles atómico, subatómico y nuclear, donde resulta totalmente imprescindible. Pero también lo es en otros ámbitos, como la electrónica (en el diseño de transistores, microprocesadores y todo tipo de componentes electrónicos), en la física de nuevos materiales, (semiconductores y superconductores), en la física de altas energías, en el diseño de instrumentación médica (láseres, tomógrafos, etc.), en la criptografía y la computación cuánticas, y en la Cosmología teórica del Universo temprano. De manera que la Teoría Cuántica se extiende con éxito a contextos muy diferentes, lo que refuerza su validez.

Pero, ¿por qué falla la teoría clásica en su intento de explicar los fenómenos del micromundo? ¿No se trata al fin y al cabo de una simple diferencia de escalas entre lo grande y lo pequeño, relativa al tamaño de los sistemas? La respuesta es negativa. Pensemos que no siempre resulta posible modelar un mismo sistema a diferentes escalas para estudiar sus propiedades.

Para ver que la variación de escalas es un proceso con ciertas limitaciones intrínsecas, supongamos que queremos realizar estudios hidrodinámicos relativos al movimiento de corrientes marinas. En determinadas condiciones, podríamos realizar un modelo a escala lo suficientemente completo, que no dejase fuera factores esenciales del fenómeno. A efectos prácticos una reducción de escala puede resultar lo suficientemente descriptiva.

Pero si reducimos la escala de manera reiterada pasaremos sucesivamente por situaciones que se corresponderán en menor medida con el caso real. Hasta llegar finalmente a la propia esencia de la materia sometida a estudio, la molécula de agua, que obviamente no admite un tratamiento hidrodinámico, y habremos de acudir a otro tipo de teoría, una teoría de tipo molecular. Es decir, en las sucesivas reducciones de escala se han ido perdiendo efectos y procesos generados por el aglutinamiento de las moléculas.

De manera similar, puede pensarse que una de las razones por las que la Física Clásica no es aplicable a los fenómenos atómicos, es que hemos reducido la escala hasta llegar a un ámbito de la realidad “demasiado esencial” y se hace necesario, al igual que en el ejemplo anterior, un cambio de teoría. Y de hecho, así sucede: la Teoría Cuántica estudia los aspectos últimos de la substancia, los constituyentes más esenciales de la materia (las denominadas “partículas elementales”) y la propia naturaleza de la radiación.

continuará

.jpg)