Por qué confundimos el color del vestido

Por ENRIQUE LUIS LICCARDI SAÑUDO

profesor en ETP

Algunos

lo ven azul y negro, otros blanco y dorado.

La

clave está en el cerebro

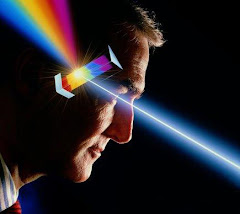

La luz

entra al ojo a través del cristalino, una estructura de lentes naturales que permiten

hacer foco. Entonces la retina, que está ubicada en la parte trasera del ojo, dispara conexiones neuronales en la corteza visual, el

área del cerebro que procesa esas señales lumínicas y las convierte en una

imagen.

Determinadas

señales lumínicas se corresponden con determinados colores. Así se explica que, al ver un

objeto, casi todas las personas lleguen a la conclusión de que el color es uno

y no otro.

El problema

es que el ojo no capta exclusivamente la luz que reflejan las cosas en

las que se está fijando. Todo el entorno también está reflejando

luz, y todo llega al ojo. Para evitar confusiones, el cerebro automáticamente

pone en segundo plano los haces que llegan desde el fondo, y se concentra en

aquellos que provienen de los objetos fijados por la vista.

¿Cómo se

explica entonces el desacuerdo en torno a la imagen del vestido

blanco-doraro o azul-negro que desde que fuera compartido originalmente por

el usuario Swiked en Tumblr ha

iniciado una verdadera revolución en las redes? "He estudiado diferencias

individuales en la percepción de los colores por más de 30 años, y ésta es una de las mayores diferencias

que he visto", dijo el neurocientífico Neitz, de la Universidad

de Washington, consultado por Wired.

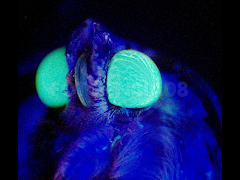

La razón es

que esa imagen en particular -no el vestido en sí mismo-,

por la combinación de luces y sombras, se encuentra en una especie de frontera

de percepción. Esto quizás se deba a que en el

fondo hay una luz muy intensa, lo que dificulta el trabajo del

cerebro para discriminar el color del objeto en el que se están concentrando

los ojos.

Los editores

de fotografía de Wired analizaron la foto con Photoshop y

los valores cromáticos indicaban que el color del vestido, según se

ve en la imagen difundida, es azul y naranja oscuro.

"Lo que

está pasando aquí es que, cuando nuestro sistema visual mira a esta cosa,

intenta rebajar el sesgo cromático producido por

la luz del sol", explicó el neurocientífico Bevil Conway,

especialista en el estudio del color y la visión.

Así, el

cerebro de algunos atribuye el azul a la luz del fondo,

entonces lo rebaja del vestido. Esas personas lo terminan viendo blanco y

dorado. Pero otros atribuyen el anaranjado o dorado al entorno, lo rebajan del

vestido, y acaban viéndolo azul y negro.

De todos

modos, independientemente de cómo se ve en la foto, la marca que lo

confecciona, Roman Originals, confirmó que el color original es azul y

negro.

Fuente: INFOBAE

.jpg)